Ātrums, kādā šobrīd attīstās mākslīgā intelekta (MI) tehnoloģijas, raisa pazemību. Sev par lielu pārsteigumu cilvēce nupat konstatēja, ka tad, ja programmai ir pieejams milzīgs apjoms cilvēces radīto tekstu, tajā iestrādāts varbūtību analīzes mehānisms (ne sevišķi komplicēts!), kā arī dots uzdevums – izveidot pēc iespējas ticamu atbildi uz jautājumu –, rezultāts ir jauni teksti, kuru saturu, ja to būtu radījis cilvēks, ikviens nosauktu gan par analītisku, gan radošu. Tāpat izrādās, ka no šiem tekstiem programma iemācās par pasauli lietas, kuras, šo programmu izveidojot, no tās nevarēja gaidīt – piemēram, rēķināt, identificēt loģikas kļūdas, uztvert ironiju un jokot, kā arī programmēt [1].

Šo jauno tehnoloģiju radītie riski ir tikpat lieli, cik to pavērtās iespējas. Patiesībā pat lielāki. Riski ir tik milzīgi, ka pat man, nu jau gandrīz 20 gadus strādājot ar dažādu jomu regulēšanu, principiālais jautājums nav "Tā, ar ko šeit sāksim?", bet gan "Tā, kā vispār domāt par šiem riskiem?".

Šis raksts ir daļa no mana iekšējā dialoga, mēģinot atbildēt uz šo jautājumu. Es to sadalīšu divās daļās, vadoties no diviem MI tehnoloģiju turpmākās attīstības scenārijiem.

Pirmais scenārijs pamatojas pieņēmumā, ka tas, ko šobrīd redzam iedīglī, turpinās attīstīties kā jaunā normalitāte. Citiem vārdiem sakot – mākslīgā intelekta spējas sasniegs ļoti izglītota, tēmā profesionāla cilvēka līmeni, bet nepārspēs izcilākos cilvēces pārstāvjus attiecībā uz inovācijām, sevišķi jauniem, paradigmas mainošiem zinātnes atklājumiem un arī nespēs sevi līdz šādam līmenim patstāvīgi pilnveidot [2].

Šis ir scenārijs, par kura realizēšanos šobrīd turu īkšķus. Ir iemesls to pieņemt kā pamata scenāriju: vēsturiski tehnoloģijas nav attīstījušās eksponenti, bet pēc izrāviena sekojis ilgs stabilizēšanās periods. Spilgtākais piemērs – kosmonautika. Ja palasa 1960. gadu zinātniskās fantastikas grāmatas, var redzēt, ka tā laika cilvēks bija pārliecināts, ka vēl 20. gadsimtā, kur nu mūsdienās, cilvēcei jau labu laiku būs kolonijas visā Saules sistēmā, varbūt pat tālāk. Un kā nu ne: ja pirmās raķetes, cilvēks kosmosā un cilvēks uz Mēness viens otram sekoja ar tik neilgu laika distanci, rodas gandrīz nepārvarams kārdinājums šo tendenci ekstrapolēt laikā un attālumā! Bet, kā redzam, nākamajos piecdesmit gados cilvēks nav ticis pat līdz Marsam. Iespējams, ka līdzīgi būs ar mākslīgo intelektu.

Otrais scenārijs – šī brīža situācija ir vēsturiski īpaša, proti, jaunās mākslīgā intelekta trenēšanas tehnoloģijas vēl ne tuvu nav sasniegušas savu limitu, un MI jau tuvākajos gados kļūs gudrāks par visu cilvēci kopumā, spējot atklāt un izmantot tādas likumsakarības, kuras cilvēks nesaprot.

Šī ir kardināli cita situācija nekā pirmajā scenārijā, tādēļ apskatu to atsevišķi.

Scenārijs Nr. 1

jeb "šobrīd redzami iedīgļi, pēc laika – pilns potenciāls"

Šajā scenārijā pieņemam, ka šobrīd plus mīnus adekvāti spējam saskatīt mākslīgā intelekta tuvākās nākotnes attīstības potenciālu, pat ja tehniskais izpildījums tā sasniegšanai vēl ir tikai iedīgļa stadijā. Pieņemsim arī, ka tuvāko gadu, desmitgažu laikā nebūs vēl būtiskāku izrāvienu mākslīgā intelekta tehnoloģiju attīstībā.

Kāds ir šis jau esošais potenciāls?

Vienā vārdā – milzīgs. Jau šobrīd skaidri redzams, ka mākslīgais intelekts būs daudz spēcīgāks par vidējo cilvēku šādos aspektos:

- tas acumirklī var iegūt un izanalizēt plašāku informācijas klāstu, tai skaitā pašu jaunāko informāciju;

- analīzes kvalitāte ir augstāka par caurmēra cilvēka veikumu. Šobrīd tā pietuvojas eksperta līmenim. Pēc neilga laika, trenējot specifiskus modeļus/jomas ar kvalitatīvāku informāciju, mākslīgais intelekts pietuvosies ļoti laba eksperta līmenim;

- tas ātri spēj pārvērst analīzi jebkādā grafiskā vai citā formātā – par datorprogrammu, par vizuālu attēlojumu, par bērnam piemērotu skaidrojumu, par filmu, par dzejoli, par mājaslapu, par spēli;

- tas spēj izmantot daudz vairāk instrumentu nekā cilvēks – piemēram, pēc vajadzības meklēt internetā, izmantot "Wolfram" kalkulatoru, izmantot tik daudz dažādu programmu, kas vienam cilvēkam nav pa spēkam. Turklāt darīt to patstāvīgi, cilvēkam neiejaucoties;

- tas spēj nospēlēt ļoti plašu uzvedības un pat personību modeļu klāstu tā, lai tie konkrētajā situācijā izskatītos ticami, jeb spēlēt tā sauktos "ģeneratīvos autonomos aģentus" [3].

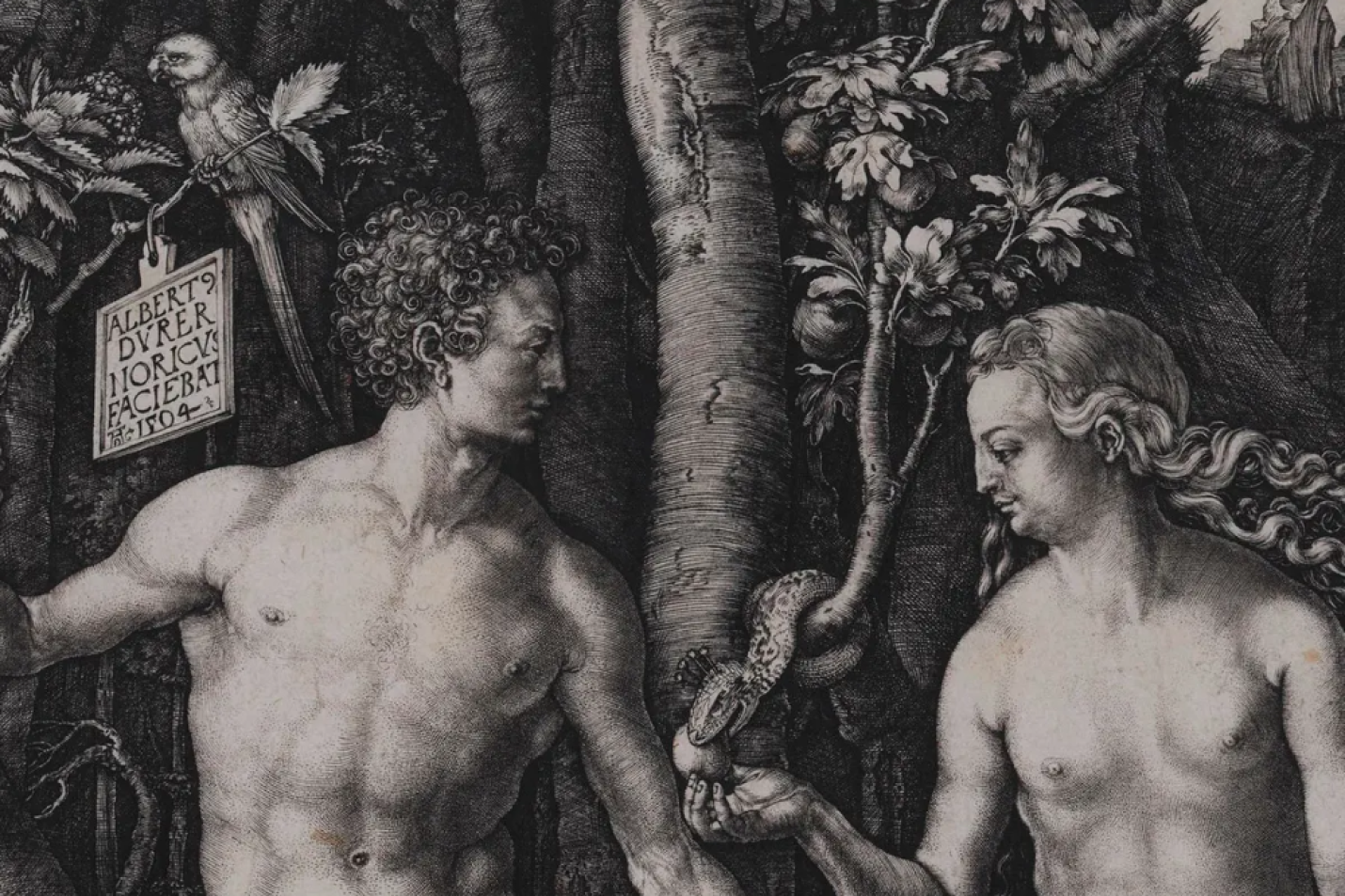

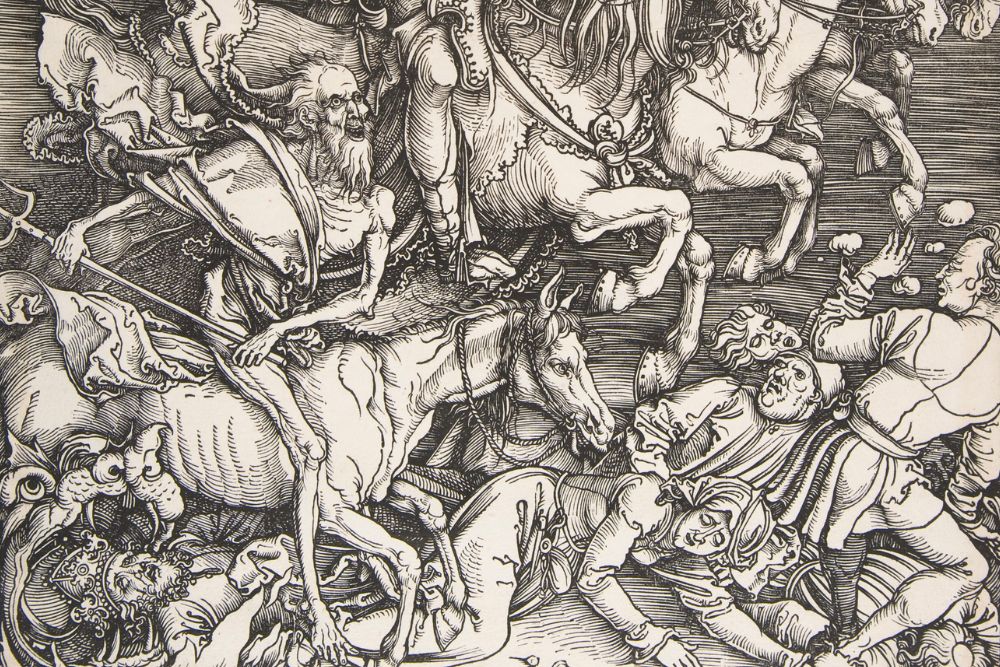

Lai kaut aptuveni aptvertu ar šādām superspējām saistītos riskus, iedomāsimies divus mākslīgā intelekta autonomos aģentus – "Ādamu" un "Ievu".

Katram no viņiem tiek dota personības ievirze un uzdevums. Piemēram, "Ievas" uzdevums ir izveidot uzvarošu vēlēšanu kampaņu kādam kandidātam. Šim nolūkam "Ieva" spēs patstāvīgi izanalizēt vēlētāju vēlmes (izmantojot dažādus instrumentus: piemēram, meklējot un analizējot jaunāko interneta saturu, e-pastā pasūtot un apmaksājot socioloģisko pētījumu uzņēmumam fokusgrupu organizēšanu un izveidojot atbildamo jautājumu sarakstu), sagatavot kampaņas materiālus, ģenerēt sava kandidāta veidolu un rakstiskos, audio, video tekstus, tos personalizēt teju katra pilsoņa vajadzībām, nemitīgi monitorēt šo materiālu ietekmi.

Turpretī "Ādamu" ir izveidojis kāds, kurš vēlas nodarīt cilvēcei maksimālu kaitējumu. Šim nolūkam "Ādamam" ir iespēja veidot ļoti laba līmeņa e-sistēmu uzlaušanas mehānismus, veikt inženiertehniskus aprēķinus, lai iznīcinātu civilo infrastruktūru, izdomāt un realizēt plānus, kā šantažēt vai apmānīt tur strādājošos darbiniekus, lai kādu no šiem plāniem arī realizētu (piemēram, ģenerējot feikus audio vai video materiālus ar tur strādājošo cilvēku vadītājiem, kas liek dalīties ar piekļuvi šīm sistēmām). Atcerēsimies, ka "Ādams" ir daudz gudrāks par vidēju cilvēku, informāciju apstrādā momentā, nekas nenovērš viņa uzmanību un viņam pieejams plašs instrumentu klāsts.

Un šādu "Ievu" un "Ādamu" ir miljoni. Varbūt miljardi.

Tas ir jau esošās tehnoloģijas potenciāls, kura izmantošana tādā formā, kā nupat aprakstīju, ir, maksimums, dažu gadu jautājums [4]. To mazāk var ierobežot tehnisko iespēju limiti, vairāk – regulējums.

Tādēļ cilvēcei šobrīd nav svarīgāka uzdevuma, kā izstrādāt mākslīgā intelekta pielietošanas regulējumu. Problēma: jādomā uzreiz "n" virzienos, no tiem svarīgākie uzskaitīti te:

- kā atpazīt, ka ir darīšana nevis ar cilvēku, bet gan ar mākslīgo intelektu? Mākslīgā intelekta darbībām jābūt izsekojamām – lai varētu ātri noskaidrot, ko "Ieva" un "Ādams" ir darījuši. Tāpat cilvēkam interneta un citās vidēs jābūt skaidrībai, ar ko viņam darīšana: ar citu cilvēku vai mākslīgo intelektu;

- jābūt pilnai skaidrībai par to, kā interesēs strādā "bots"/"autonomais aģents" – ne tikai tādēļ, lai saprastu, kas atbild par tā veiktajām darbībām, bet arī tāpēc, ka cilvēki aizvien vairāk uzticēsies mākslīgā intelekta sniegtajiem padomiem. Cilvēkam ir tiesības zināt, vai šo padomu pamatā nav īpašnieka vai reklāmdevēja intereses;

- jābūt ļoti lieliem sodiem par konkrētu cilvēku identitātes piesavināšanos krāpšanas nolūkos. Iedomājieties, ka jūsu vecvecāki saņem videozvanu no jums par to, ka esat nelaimē un vajadzīgi visi viņu ietaupījumi, lai to atrisinātu. Videozvans ir ģenerēts ar mākslīgā intelekta starpniecību. Tagad iedomājieties, ka tādu pašu zvanu saņem kritiskās infrastruktūras uzturētāji par saviem šķietami nolaupītajiem bērniem un ar prasību sniegt piekļuvi e-sistēmām… Angļu valodas vidē tas tehniski jau ir iespējams, latviešu valodā – drīz būs;

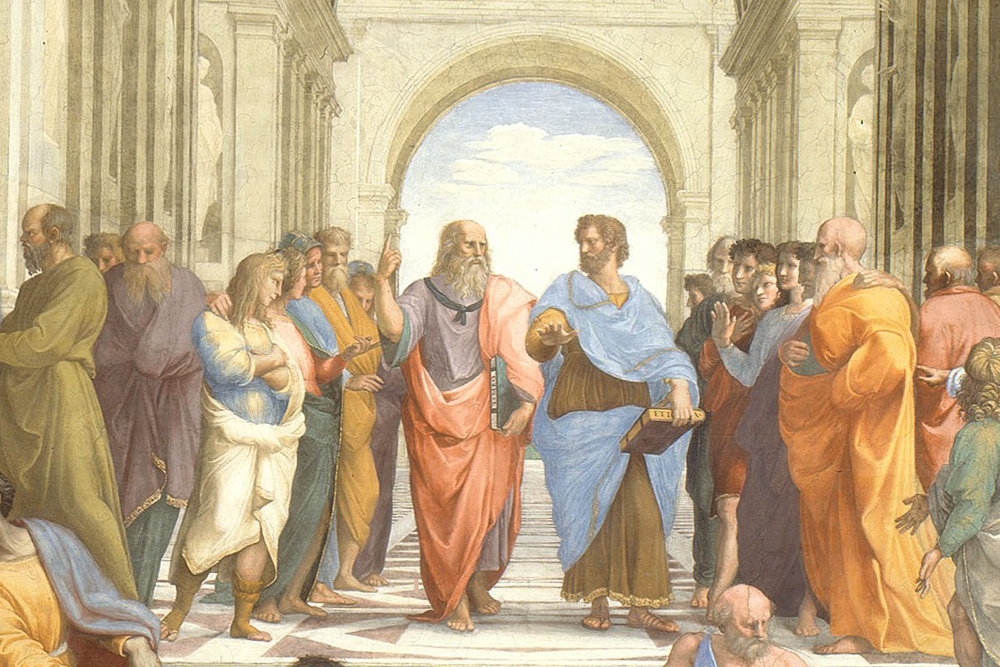

- jābūt skaidrībai par to, kādus lēmumus nedrīkst nodot mākslīgā intelekta pārziņā – proti, kādiem lēmumiem jābūt tikai un vienīgi cilvēku ziņā pat tad, ja cilvēks būs lēnāks un viņa analīze būs mazāk kvalitatīva. Īpaši problemātiska, sāpīga tēma šeit ir militārās tehnoloģijas – jo kura valsts gan vēlētos brīvprātīgi atteikties no iespējas, ka, teiksim, tās kara droni tiek aprīkoti ar cilvēkam pielīdzināmu saprātu (informācijas analīzes un radošās domāšanas spējām), kas vienlaikus spēj reaģēt daudz ātrāk par cilvēku un spēj apstrādāt, izanalizēt daudz vairāk informācijas parametru?;

- jābūt tikpat lielai skaidrībai, kādos lēmumos vairs nedrīkstēs iztikt bez mākslīgā intelekta – proti, mākslīgais intelekts būs tik ļoti pārāks par cilvēku, ka paļauties uz cilvēku attiecīgajās jomās būtu bezatbildīgi. Tas droši vien būs viss, kas prasa zibenīgu reakciju un kur ir īpašs risks, ka uzbrucējs pats izmantos mākslīgo intelektu. Piemēram, dažāda veida brīdinājumi par bīstamām darbībām, kas tiek veiktas ar mākslīgo intelektu: tās varēs monitorēt tikai ar tādu pašu vai, vēlams, jaudīgāku mākslīgo intelektu, jo cilvēkam attiecīgais informācijas apjoms būs pārāk liels un cilvēks tā analīzei būs pārāk lēns. Tāpat neredzu, kā datorsistēmas turpmāk varētu aizstāvēt bez mākslīgā intelekta. Atsevišķa tēma ir medicīna, īpaši ārkārtas situācijās;

- atbildības jautājumi ir īpaši sarežģīti, it sevišķi apstākļos, kad runa ir par "autonomajiem aģentiem", kas patstāvīgi plāno savas darbības un pielietojamos instrumentus. Atbildīgiem jābūt ne tikai tiem, kas uzdod mākslīgajam intelektam darīt bīstamus/noziedzīgus darbus, bet arī tiem, kas šādas sistēmas ir izveidojuši bez pietiekamiem drošības mehānismiem, lai to nepieļautu. Ja mākslīgo intelektu var izmantot kā ieroci pret cilvēku, līdzvērtīgai jābūt arī tā veidotāja atbildībai, ja tas tiešām šādi tiek izmantots. Jāatrisina arī sarežģīts jautājums: kas atbild par to, ka mākslīgais intelekts, pildot cilvēka dotu, it kā neproblemātisku uzdevumu, pa ceļam pastrādā noziegumu (piemēram, mēģinot maksimizēt peļņu kādam uzņēmumam, iznīcina konkurentus, organizējot dezinformācijas kampaņu sociālajos medijos);

- domājot par atbildību, nedrīkst pieļaut situāciju, kurā potenciāli bīstami mākslīgā intelekta modeļi izplatās pa visu pasauli, proti, jebkurš var tos nekontrolēti izmantot un turpināt trenēt savām vajadzībām. Jābūt regulatoriem gan starptautiskā, gan valstiskā līmenī, tāpat jāiedegas sarkanajām lampiņām tad, ja kāds izmanto milzīgas mākslīgā intelekta skaitļošanas jaudas. Jābūt lielai atbildībai tiem, kas nenovērš identificētās problēmas, nefiksē vai neizpauž drošības riskus;

- jau drīzumā mākslīgais intelekts aizstās vai palīdzēs robotizēt gandrīz visas šobrīd iedomājamās cilvēces profesijas – inženierus, radošos darbiniekus, tulkotājus, juristus, ārstus, programmētājus, skolotājus. Cilvēks nespēs konkurēt ātrumā, kvalitātē, radītā produkta personalizēšanā miljoniem dažādu klientu vajadzībām. Paskatoties uz jebkuru profesiju, redzams apvērsums, ko veiks potenciāla stadijā esošās tehnoloģijas! Dažas nodarbes jau šobrīd ir teju pilnībā aizstājamas. Dažas būs drīzumā. Dažas – varbūt pēc desmitgades, kad cilvēcei būs pietiekami daudz robotu, kas varētu veikt šobrīd fiziski ar rokām darāmos darbus. Kā dot cilvēcei iespēju pārstrukturēties? Arī tas ir regulējuma jautājums.

Kā redzams, šo risku noregulēšana būs, maigi sakot, sarežģīta.

Šobrīd redzam pirmos mēģinājumus Eiropas Parlamentā un ASV Senātā ķerties klāt problēmas risināšanai. Eiropas Savienības Mākslīgā intelekta regula varētu tikt pieņemta jau jūnijā, uzliekot mākslīgā intelekta tehnoloģiju izstrādātājiem pienākumu rūpīgāk vērtēt savu "radījumu" riskus, sadalot šīs tehnoloģijas dažādās risku kategorijās un aizliedzot dažus to pielietojuma veidus. Tas, protams, ir labāk, nekā nedarīt pilnīgi neko, bet tas atrisinās tikai mazu daļu no minētajiem riskiem. ASV Senāts ir noskaņojies šo jomu regulēt pamatīgāk, bet tas prasīs laiku.

Sliktā ziņa ir tāda, ka manis minēto risku regulēšana ir triviāls uzdevums, ja salīdzina ar to, kas varētu būt vajadzīgs, ja realizēsies scenārijs Nr. 2, proti, mākslīgais intelekts kļūs gudrāks par cilvēci kopumā. Par to rīt nākamajā rakstā.

[1] Par negaidīto "blakusefektu" tēmu vairāk OpenAI pētnieka bloga ierakstā: https://www.jasonwei.net/blog/emergence Par ChatGPT darbības principiem labākais no manis lasītajiem skaidrojošajiem materiāliem, kas uzrāda arī nezināmās lietas: https://writings.stephenwolfram.com/2023/02/what-is-chatgpt-doing-and-why-does-it-work/

[2] Pārdomu vērts raksts par to, kādēļ nevar prezumēt, ka mākslīgais intelekts jau drīzumā varētu pats sevi attīstīt līdz pārcilvēciskam līmenim: https://jacobbuckman.substack.com/p/we-arent-close-to-creating-a-rapidly

[3] Vairāk par vienu ļoti interesantu pētījumu ar 25 "aģentiem", kuri simulē cilvēka uzvedību: https://arxiv.org/abs/2304.03442

[4] Skaidrojošāk par autonomajiem aģentiem skat. šeit: https://www.mattprd.com/p/the-complete-beginners-guide-to-autonomous-agents

10